- Estadística: es la base, definiendo la recolección, organización e interpretación de los datos. En otras palabras, es el oxígeno. Sin esta ciencia, no hay vida (para analizar datos).

- Lenguaje de Máquinas: diseño y desarrollo de algoritmos para modificar el comportamiento de las computadoras, en base al análisis de datos. Por esta última parte de la definición es que un gran número de algoritmos de este campo utilizan técnicas estadísticas. Lenguaje de máquinas es un área muy interesante y con mucho futuro.

- Álgebra Lineal: Trata sobre el estudio de vectores, matrices y campos vectoriales. Uno de sus beneficios es que permite el analisis en paralelo de los datos, lo que ayuda al manejar grandes cantidades de datos. Ademas la arquitectura de computadoras también ya permite este tipo de análisis/cálculos.

domingo, 26 de septiembre de 2010

Cómo ser un científico de datos (en seguridad informática)?

domingo, 5 de septiembre de 2010

Implementación del DNSSEC y algunas expectativas falsas sobre el PKI

y sub-director de informática (pero almacenadas en un lugar seguro y secreto :)

domingo, 15 de agosto de 2010

Cinco razones de por que asistir a Usenix Security

- Oportunidad de conocer trabajos de investigación con potencial para convertirse en productos de ingeniería. UsenixSec es sobre investigación aplicada por lo que la validez de una idea e investigación depende de su aplicación en la industria. En la conferencia, expertos provenientes de industria y academia dieron su evaluación sobre el trabajo presentado e incluso realizaron comparaciones con otros trabajos/productos similares.

- Si eres estudiante o profesor de primer año, oportunidad de conseguir fondos para asistir. Usenix ofrece becas para asistir a sus eventos, incluyendo a UsenixSec. El proceso para aplicar es fácil y se puede realizar en línea. Yo llené toda la información en cuestión de días (ya que debes hacer un ensayo, así que me tomé el tiempo para revisarlo y corregirlo). La beca que me otorgaron cubrió el 70% de mis gastos.

- Participar en pista de charlas de la industria. Escuchar a los especialistas que están decidiendo e implementando los mecanismos de seguridad en los productos utilizados hasta por cientos de millones de personas, no tiene precio. En la conferencia de este año habló Crispin Cowan sobre los avances en seguridad de Unix y Windows en los últimos 10 años. Cowan es una de las pocas personas, en mi opinión, que puede hacer una comparación objetiva ya que ha desarrollado varios programas de seguridad para Unix para luego ingresar a Microsoft en 2008.

- Oportunidad para conversar con verdaderos expertos de seguridad que asisten anualmente. Este año asistieron expertos como Steven Bellovin, Bill Cheswick, Simson Garfinkel, Farnam Jahanian, Chris Kruegel, Wenke Lee, Peter Neumann, Niels Provos, Avi Rubin, Chris Schuba y Robin Sommer. En cada una de las actividades sociales de la conferencia (breaks, sesiones de poster, cena, etc.) se tiene la oportunidad de conversar con ellos y debo añadir que la gran mayoría siempre está muy dispuesto a conversar. Por ejemplo, hablé con Bellovin sobre la mal ganada fama de los PKI (algo de lo que comentaré después aquí) y con Sommer sobre el futuro del sistema de detección de intrusos Bro. Las opiniones ofrecidas por cada uno, demuestran el conocimiento profundo que tienen en seguridad informática.

- Oportunidad para conocer otros colegas de la seguridad informática y darte a conocer. Mientras se es estudiante de investigación (MSc y PhD), resulta muy interesante y divertido conversar y convivir con otras personas que están pasando por la misma experiencia y tienen intereses similares. Esta podría incluso ser la razón más importante por la que un estudiante debe asistir a conferencias como Usenix Security. Las primeras cuatro razones sólo mejoran la experiencia exponencialmente... :)

martes, 3 de agosto de 2010

Cómo evaluar/medir las vulnerabilidades y a cuáles debo prestarles atención primero?

- Afecta a recursos de alto valor? 1 punto

- Afecta la infraestructura de red (ej. conmutadores, murallas de fuego, DNS)? 1 punto

- Afecta a un producto ampliamente usado o instalado en la ACP? 1 punto

- Afecta instalaciones por defecto de un producto? 1 punto

- Existe código disponible públicamente que aproveche la vulnerabilidad o está siendo ejecutada ampliamente en el Internet? (ej. virus) 1 punto

- La vulnerabilidad se puede acceder remotamente? 1 punto

- La vulnerabilidad se puede acceder sin credenciales? 1 punto

- Se han publicado detalles técnicos de la vulnerabilidad? 0.5 punto

- El resultado permite acceso administrativo o con privilegios? 1 punto

- Se requiere de ingeniería social (ej. visitar un sitio, hacer clic sobre un enlace web) para aprovechar la vulnerabilidad? 0.5 punto

- Existen registros de auditoria en la ACP que demuestran intentos o ataques utilizando la vulnerabilidad? 1 punto

Les recomiendo leer el documento de Bozorgi ya que es un excelente documento para aprender más de la técnica propuesta y también un buen ejemplo sobre como presentar resultados en una publicación científica. Al leerlo, uno puede determinar que la técnica propuesta posee limitaciones. Para comenzar, la técnica sólo busca determinar cuan rápido será implementada una vulnerabilidad. Mientras tanto, los métodos de ACP y CVSS buscan determinar cuan peligrosa es una vulnerabilidad (lo que no solo depende de si la vulnerabilidad ha sido implementada o no). Adicionalmente, en el sitio web del proyecto no está disponible (al momento de escribir este artículo) el dataset utilizado para calcular los valores presentados en el documento. Esto impide que uno mismo puede validar los resultados. Al final, los autores del documento sugieren que se utilicen técnicas estadísticas como complemento a las técnicas heurísticas. Esto será más viable a medida que continua nuestra uso y dependencia en sistemas informáticos, lo que generará más y mejores grupos de datos para ser analizados con técnicas como Linear SVM.

sábado, 24 de julio de 2010

Qué lenguaje de programación debo aprender? En julio es Java

La respuesta correcta es cualquiera, pero con una observación importante. Puedes escoger cualquier lenguaje pero debes aprenderlo bien. O sea, a profundidad. Este ha sido uno de los mejores consejos de tecnología que me han dado (gracias Rob!) ya que es muy probable que todo lo que uno quiere o necesita hacer, se puede lograr con cualquiera de los lenguajes más populares. El problema es que no siempre uno aprende todo lo necesario para resolver la mayoría de las tareas que uno enfrenta. Por esta razón es que cuando decidas aprender un lenguaje, explora todas las opciones que te ofrece. En ocasiones esto significa aprender más sobre las librerías o paquetes disponibles o las funciones o estructuras de datos que permite utilizar un lenguaje.

Una buena razón de aprender bien un lenguaje de programación es que varios de los conceptos utilizados (propiedades) al desarrollar el lenguaje, son también utilizados en otros lenguajes. Esto facilita que cuando desees aprender otro lenguaje, la transición sea más sencilla que si no supieras ningún lenguaje. Como ejemplo, tienes los lenguajes orientados a objetos como Java, C++ e incluso lenguajes scripting como Python.

Ok, pero que ocurre si alguien quiere una respuesta más sencilla a la presentada arriba? Que tal si la persona que quiere aprender sobre programacion desea que le indiquen un lenguaje y que no tenga que tomar la decisión religiosa por su cuenta? Entonces tengo dos comentarios. Primero, el lenguaje de programación a aprender dependerá del área en donde trabajes o desees trabajar. Por ejemplo, si eres o deseas trabajar en el área de tecnologías Web, entonces te conviene aprender lenguajes como Java, Javascript, C# o PHP. Si eres más un administrador de sistemas, es posible que debas prestarle atención a lenguajes tipo scripting como Perl o Python.

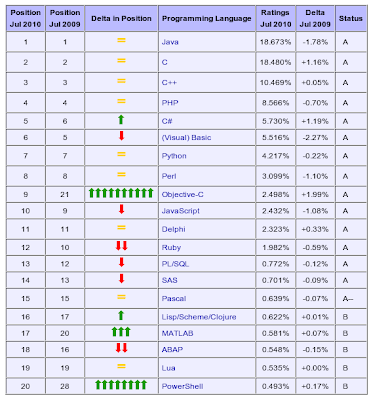

El segundo comentario es que puedes darle una ojeada al índice de programación TIOBE. Este índice está basado en la popularidad de los distintos lenguajes de programación. Para calcularlo, se utiliza los buscadores Web como Google, MSN y Yahoo! y es una manera de medir la popularidad de los lenguajes. Los autores han publicado mensualmente este índice desde el año 2001. Abajo aparece el resultado para este mes, julio 2010.

Aunque los resultados no necesariamente sorprenderán a muchos (Java, C y C++ son los tres más populares), es interesante ver las tendencias y cambios que varios de estos lenguajes reportan en distintos meses. En la tabla de arriba, la columna 5 indica el índice del lenguaje, seguido por el cambio en comparación a un año atrás y la columna 7 indica la categoría del lenguaje. Un lenguaje categoría A es considerado "mainstream" o de uso popular. La definición completa del índice, así como de las categorías, la puedes encontrar aquí.

Al final, el índice TIOBE tampoco responde a la pregunta original sobre el tipo de lenguaje que uno debe aprender. Pero como buenos ingenieros si provee luces sobre cuán populares pueden ser los lenguajes (de acuerdo a lo que indica solamente el Internet, o la parte de él que revisan los buscadores) y nos da números, lo que nos permite pensar y decidir analíticamente. Y eso le puede dar paz a uno... al menos si eres ingeniero. :)

miércoles, 7 de abril de 2010

Qué hace DHS en temas de seguridad informática?

- Mike McConnell, ex-Director de NSA (National Security Agency, o como dicen algunos, No Such Agency :)

- Randy Beers, actual sub-secretario para DHS (Department of Homeland Security) y

- Dr. David Bell (el mismo del modelo de control de acceso Bell-Lapadula).

Para quienes no pudieron asistir, CERIAS ha publicado las notas del evento en su blog: http://www.cerias.purdue.edu/site/blog/. Además de asistir al evento, participé tomando las notas de la presentación del Sr. Beers, las cuales están disponibles [aquí]. Durante su charla, me pareció interesante escuchar como el gobierno de Estados Unidos, y DHS en particular, está manejando el tema de la seguridad informática para proteger los recursos gubernamentales y los sistemas informáticos relacionados a la infraestructura crítica del país. Fue evidente notar que para EEUU y el éxito futuro de su economía, manejar apropiadamente la seguridad informática es indispensable. El Sr. Beers incluso habló de algunas iniciativas técnicas a nivel nacional como el equipo de respuestas a incidentes US-CERT y el sistema de detección de intrusos (IDS) llamado Einstein.

Para aquellos que nos gusta sumergirnos en temas técnicos, siempre es bueno escuchar el "resto de la historia". Seguridad informática es mucho más que sólo los aspectos de tecnología. El Simposio de CERIAS permitió ver y escuchar sobre aspectos y esfuerzos no-técnicos, que son necesarios para el éxito de cualquier programa de seguridad informática. Especialmente si se trata de proteger los intereses de una nación como los EEUU.

jueves, 25 de marzo de 2010

Se solicita asistente de investigación para estudio del Internet en Panamá

He aquí la información detallada de la posición:

El candidato ideal participará en el desarrollo y administración de la plataforma informática para culminar exitosamente el proyecto. Se espera que el candidato posea conocimientos comprobados (por medio de cursos o trabajos realizados) en instalación de sistema operativo Linux/Unix y lenguajes de programación tipo “scripting”.

Esta pasantía le ofrecerá al candidato la oportunidad de adquirir habilidades técnicas y experiencia de investigación, durante los ocho (8) meses que dura el proyecto. Participará con el resto de los investigadores en producir los entregables del proyecto.

RESPONSABILIDADES

- Apoyar en la implementación de la plataforma informática del proyecto

- Apoyar en la recolección de los datos para estudio de topología y tráfico

- Apoyar en el análisis de los datos recolectados

- Administrar y mantener la plataforma informática, basada en sistema operativo Linux

- Desarrollar programas de automatización (scripts) de tareas periódicas

- Diseñar, administrar y mantener la seguridad del sitio web del proyecto, el cual estará basado en HTML y JavaScript (o un manejador de contenido)

- Comunicar estado de tareas (por medio de reportes de avance y notificación oportuna a superiores de problemas y riesgos)

- Realizar respaldos periódicos (diarios y semanales) a plataforma informática y datos del proyecto (relacionados con topología y trafico)

- Tener disponibilidad para desplazarse a distintos puntos de la ciudad de Panamá para realizar revisiones del equipo utilizado

- Participar en las reuniones semanales con resto del equipo

REQUISITOS

- Ser ciudadano panameño

- Estar cursando actualmente carreras de licenciatura o maestría en áreas de tecnologías de información y comunicaciones (TIC). Por ejemplo: ingeniería electrónica, sistemas computacionales, ingeniería de software

- Mantener un índice académico acumulativo de 2.0 o superior (sobre escala de 3.0)

- Tener experiencia (curso o trabajo realizado) en redes de computadoras basadas en protocolos TCP/IP

- Tener experiencia (curso o trabajo realizado) en al menos un lenguaje de programación tipo “scripting” (Perl, Python, Shell Scripting)

- Tener experiencia (curso o trabajo realizado) instalando, configurando y administrando sistemas con sistema operativo Linux

- Poseer habilidad para cumplir metas en plazos establecidos

- Poseer habilidad para trabajar independientemente y como parte de un equipo

- Experiencia en desarrollo de aplicaciones basada en tecnologías Web, basados en HTML y JavaScript

- Experiencia en al menos un lenguaje de programación de alto nivel (C, C++ o Java)

- Experiencia en administración de sistemas de respaldo, basados en tecnología RAID

- Experiencia en administración de dispositivos de red (router) con sistema operativo Cisco-IOS

- Fuerte habilidad para comunicarse oralmente y por escrito

viernes, 19 de marzo de 2010

XIII Congreso Nacional de Ciencia y Tecnología, 6 al 9 de Octubre 2010

El Comité Organizador del congreso invita a participar en las distintas modalidades de publicación (conferencias por Invitación, simposios, comunicaciones libres orales, afiches y mesas redondas) y recibirá los resúmenes de trabajos de investigación hasta el próximo 31 de agosto de 2010. Las áreas temáticas incluyen las distintas ramas de la ciencia y tecnologia, incluyendo: ingenierías y Ciencias Computacionales, tecnología de la información y la comunicación, aspectos éticos y legales de la actividad científica y tecnológica, biotecnología, educación y energía.

El costo por participante (profesional, no miembro de APANAC) es de $60, hasta el 31 de agosto de 2010 y $70 después. Para profesionales miembros hay un descuento de $10 (también aplica el descuento por pagos hechos antes del 1 de septiembre) y estudiantes pagan $30.

Fechas importantes

1 de febrero de 2010: Inicio de recepción de resúmenes

31 de agosto de 2010: Límite para pago anticipado

31 de agosto de 2010: Límite para la entrega de resúmenes

11 de septiembre de 2010: Entrega de evaluaciones de los resúmenes

6-9 de octubre de 2010: XIII Congreso Nacional de Ciencia y Tecnología

Para mayor información, visita la pagina web de APANAC (www.apanac.org.pa) o escribe a la dirección electrónica congreso@apanac.org.pa. No te lo pierdas!

martes, 26 de enero de 2010

Exitosa celebración del evento "ESTUDIANDO COMPUTACIÓN Y TELECOMUNICACIONES EN PAÍSES INDUSTRIALIZADOS"

Compartimos con ustedes las presentaciones que utilizaron los expositores el día del evento:

- Jesús Alvarado / Beneficios de Pertenecer a IEEE Panamá [presentación]

- Gaspar Modelo Howard / Como Aplicar y Oportunidades de Financiamiento para Panameños [presentación]

- Juan Pablo Espino / Experiencia de estudios en el Royal Institute of Technology, Suecia [presentación]

- Ramsés Morales / Aprovechando el Primer Semestre [presentación]

Adicionalmente participe como moderador de la mesa redonda Oportunidades y retos para quien estudia computación o telecomunicaciones en un país industrializado. En la misma participaron Min Chen, Karla Arosemana, Rolando Armuelles, Roberto Barnes e Iván Armuelles. Aquí encontrarán las conclusiones de la mesa y que compartimos ese día: [presentación]

En conclusión fue un evento en donde múltiples profesionales compartieron sus experiencias y recomendaciones para cursar estudios en el extranjero y los asistentes tuvieron la oportunidad de conocer distintas opciones de estudio, compartir sus inquietudes y aclarar dudas sobre los aspectos que involucra estudiar en EEUU y Europa. Agradecemos nuevamente a todos los que hicieron de este evento una realidad. Esperamos que sea de provecho (incluso para quienes no pudieron asistir pero nos visitan en esta página) y tengamos la oportunidad de repetir el evento en un futuro. Saludos!

lunes, 11 de enero de 2010

Seminario de IEEE Panama: Estudiando Computación y Telecomunicaciones en Países Industrializados

FECHA: Martes 19 de enero de 2010

HORA: 6:30PM - 9:00PM

LUGAR: Hotel Crown Plaza

COSTO: Miembros IEEE: gratis / No miembros (estudiantes): $5

He aquí la agenda del evento:

- Como aplicar y oportunidades de financiamiento para panameños

Gaspar Modelo Howard

Abstracto: Ofreceremos una descripción del proceso para aplicar desde Panamá a universidades en países industrializados (EEUU y Europa), para estudiantes interesados en carreras relacionadas con computación (maestrías y doctorados). Adicionalmente se presentarán algunas opciones de ayuda financiera disponibles a estudiantes panameños. - De Panamá a Suecia, Experiencia de Estudios en el Royal Institute of Technology

Juan Pablo Espino

Abstracto: La presentación abordará las experiencias como estudiante de maestría (Ing. Eléctrica) en Suecia. Se expondrá la estructura del sistema de educación superior sueco, información real sobre costo de vida, opciones de becas en Suecia y compañías líderes en tecnología, particularmente en ingeniería eléctrica y computación. Finalizaré con comentarios sobre las ventajas y desventajas de estudiar en Suecia de acuerdo a nuestra experiencia. - Aprovechando el Primer Semestre

Ramsés Morales

Abstracto: El primer semestre es de gran importancia: las decisiones que tomes pueden acelerar o retrasar tu programa, pueden aumentar o disminuir cuanto vas a disfrutar tus estudios y definitivamente influenciarán el área de investigación que elijas. En esta charla presentaré ideas que me habría gustado conocer antes de iniciar mi primer semestre. Considero la situación actual de estudiantes Panameños en áreas afines a computación—por ejemplo, investigación naciente en universidades Panameñas—y presento un mini‐manual que espero les sirva para referencia futura. - Mesa Redonda: Oportunidades y retos para quien estudia computación o telecomunicaciones en un país industrializado

Iván Armuelles, Rolando Armuelles, Roberto Barnes, Min Chen

Abstracto: Los panelistas discutirán las ventajas y desventajas de realizar estudios tecnológicos en un país industrializado, ¿Es una buena inversión de tiempo y dinero? ¿Existe mercado en Panamá para personas con estudios avanzados en tecnología? ¿Qué preguntas claves debe responder un individuo antes de tomar la decisión de irse a estudiar?

Por favor comparte esta información con personas interesadas. Te esperamos!